Cualquier persona que haga un seguimiento SEO de su página se puede encontrarse un día cualquiera accediendo a su cuenta de Google Analytics descubra que ha perdido gran parte del tráfico de visitas en su web… esto es algo que a todos nos preocuparía muchísimo porque como sabemos, la mayor parte de las visitas que recibe una web proviene de las búsquedas realizadas en Google y de que tengamos un buen posicionamiento web, si por cualquier motivo nuestra página ha sido objeto de alguna penalización por parte del buscador, perderemos inmediatamente un gran porcentaje visitas, incluso todas!. Por lo tanto debemos tener mucho cuidado con esto.

Lo primero que debemos saber es que hay dos clases de penalizaciones relacionadas con el SEO de nuestra web que pueden afectarnos, unas son las penalizaciones manuales y otras las penalizaciones automáticas o logarítmicas.

La mayoría de los webmasters presta atención a las acciones SEO para evitar penalizaciones por parte del algoritmo, y puede que sea porque la gran mayoría desconoce que se producen cientos de miles de sanciones manuales a páginas web cada mes, lo que supone una cifra muy elevada.

Por nuestra experiencia como agencia seo podemos decir que muchos de los sitios web que son penalizados por alguna de estas dos clases, son realmente sitios que no tienen ningún otro objetivo que el spamear. Pero la verdad es que todos los días muchísimas webs también sufren alguna de estas penalizaciones y se trata de páginas de calidad como podría ser la tuya.

Puede ser, que si llevas algún tiempo en este negocio de internet realizando acciones SEO y nunca has sufrido una penalización, creas que las informaciones sobre las penalizaciones están sobrevaloradas, pero debes prestarle atención ya que algunas sanciones pueden arrebatarte prácticamente todas las visitas a tu página web. A los ojos de Google no importa que sea un sitio web de cien visitas diarias o un gigante de la red como puede ser eBay, que fue muy perjudicado en su día por la entrada de la actualización Panda 4.0 de Google que le hizo perder gran parte de su tráfico de visitas, y hay muchos más casos como este.

Incluso empresas en las que el mismo Google invierte grandes sumas de dinero han sufrido penalizaciones seo por parte del buscador; un ejemplo de este caso es la empresa Thumbtack, la diferencia en estos casos entre un sitio potente como Thumbtack, que es muy conocido y tiene mucha publicidad por otros medios, es que apenas tardan una semana en superar la penalización y volver a rankear en los primeros puestos de Google, mientras que un sitio pequeño puede tardar semanas e incluso meses en lograrlo.

Os doy estos ejemplos para concienciar de la importancia de las penalizaciones y que tratéis de evitarlas, no para asustar a nadie. Evitar las sanciones es algo clave para un negocio online, y teniendo en cuenta una serie de penalizaciones muy habituales que realiza el buscador podrás disminuir en un altísimo porcentaje las posibilidades de sufrir una de ellas.

A lo largo de este post os voy a explicar en que consisten cada una de las penalizaciones que nos puede aplicar Google y como debemos proceder para evitar que nos afecten y lo que debemos corregir para salir de ellas en caso de que ya hayamos sido penalizados, debido a que el post es muy extenso te sugiero que lo agregues a tus favoritos para leerlo por partes, para facilitarte un poco esta tarea te he puesto un enlace que te llevará directamente a cada penalización y así te resulte más fácil leerlo.

Los tipos de penalizaciones son los siguiente:

Penalizaciones algorítmicas Google

Penalizaciones manuales Google

Panda: Contenido escaso, duplicado o de baja calidad

Lanzado por Google en el año 2011, probablemente el algoritmo más famoso, fue el primero diseñado concretamente para penalizar páginas web con escasa calidad y utilidad. En un primer momento Google lo ejecutaba una vez cada 30 o 40 días, una vez que estuvo consolidado parece que ya no se ejecuta más que 2 o 3 veces al cabo del año.

Que sólo se ejecute un par de veces al año puede parecer algo genial, pero hay que tener cuidado pues haciendo menos variaciones hay un menor número de opciones de caer en una penalización.

Al ser Panda una penalización automática por algoritmo, provoca que si somos penalizados por ella y posteriormente corregimos la causa que lo originó, no volveremos a rankear con normalidad hasta que el algoritmo vuelva a ser ejecutado y nos levante la sanción, y esto como hemos visto puede llevar varios meses de espera. Esta situación puede ser aún peor si además las medidas que hubiésemos aplicado para salir de la penalización no surtieran efecto, lo que supondría que deberías tomar otras medidas y volver a esperar otra vez a que Panda sea ejecutado de nuevo.

¿Pero… Qué es exactamente Google Panda?

Lo más curioso de este algoritmo, puede que sea el no saber con exactitud al tipo de páginas que más perjudica, a pesar de haber sido ejecutado ya en bastantes ocasiones a lo largo de los últimos años, (como todos sabéis Google se esfuerza mucho por mantener en secreto el funcionamiento de sus algoritmos) y ofrecen poca ayuda para superar estas penalizaciones, al contrario de lo que ocurre con las de tipo manual, pero si, tenemos una opinión bastante bien fundamentada y estamos convencidos de que se acerca a la realidad.

Sabemos con seguridad, que el objetivo de Panda era eliminar de los resultados de búsqueda los sitios web con contenidos de escaso valor o de poca calidad. Entonces si tenemos un sitio web con buen contenido podemos estar tranquilos, nos seguirán llegando nuestras visitas sin que Panda nos afecte, o no… Y claro es justo aquí donde reside el principal problema, ¿a qué se refiere con contenido de “calidad”?, porque parece un termino bastante ambiguo, y por ello suscitó muchas quejas por parte de los webmasters que temían poder ser objeto de esta penalización.

Para solucionar esta cuestión, Google elaboró una lista de preguntas, para poder resolver las dudas de los usuarios, pero lo cierto es que incluso estas preguntas daban lugar a diferentes interpretaciones, por lo tanto no fueron realmente muy esclarecedoras.

Con el paso del tiempo, los expertos SEO de todo el mundo, analizaron en detalle las páginas que fueron penalizadas por este algoritmo y concluyeron lo siguiente:

- Los textos eran demasiado pequeños para poder ser considerados “valiosos”

- Textos duplicados o copiados de otra página

- Los textos estaban mal escritos

- El contenido no aporta ningún tipo de valor

Este sería el típico caso que afecta a los sitios web que se usan como granjas de enlaces, que simplemente contenían un enlace al sitio web que se quería posicionar y apenas tenía texto, y el que tenía era de mala calidad o directamente copiado de otros sitios web.

¿Como funcionan exactamente las penalizaciones de Panda?

Normalmente Google siempre crea la patente de sus algoritmos y también lo hizo para Panda en el año 2014, está a disposición de todo aquel que quiera leerlo, pero para que sea más cómodo, he preparado un pequeño resumen con lo más importante:

Google prepara un factor de variación de todas las partes de la web que está analizando, si este factor desciende de cierto límite estipulado en alguna parte del sitio web, dicho factor se aplica al conjunto del sitio, provocando una caída en los rankings de todas las páginas de nuestra web. Es decir, que si tenemos una parte de nuestra web con contenido que Google detecta como escaso o de mala calidad, toda nuestra web será penalizada en conjunto.

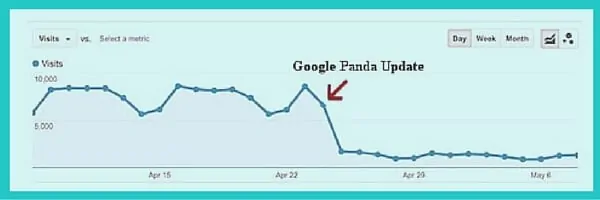

Por lo tanto, los gráficos que obtendríamos serían muy parecidos al gráfico que veis aquí debajo, puesto que no provoca una merma pequeña del tráfico orgánico, si no, muy pronunciada:

¿Cómo saber si hemos sido penalizados por Panda?

Como es lógico, Google no nos avisa de que hemos sido penalizados por uno de sus algoritmos. La forma que tenemos de darnos cuenta es revisando nuestras gráficas atentamente y realizando un seguimiento del posicionamiento SEO. Si nos vemos afectados por una sanción que nos merma la mayor parte de nuestras visitas, hay que ser consciente de que uno no está solo y que puedes consultar muchos sitios de información sobre SEO como éste, para buscar ayuda y soluciones. Si se trata de una actualización del algoritmo Panda, probablemente te des cuenta enseguida.

Hay muchas herramientas on-line y cada vez más que pueden ayudarnos a averiguar si hemos sido objeto de alguna penalización anteriormente, una de las más conocidas es Panguin Tool, se trata de una herramienta gratuita que se suma a Google Analytics y que produce la superposición de un gráfico que representa líneas de tiempo que permiten la comparación entre los diferentes algoritmos.

Si observas que los días anteriores o posteriores al lanzamiento de una actualización de Panda, el tráfico de visitas a tu web sufrió una caída muy llamativa, lo más seguro es que te haya penalizado.

El lanzamiento de estas actualizaciones de algoritmo llevan bastante tiempo, durante semanas normalmente, por lo que debes tener en cuenta que no tiene por qué coincidir la fecha concreta en que se publica la actualización de Panda y el descenso del tráfico en tu web.

Aquí tienes un post con 15 consejos SEO para evitar penalizaciones de Google Panda.

Penguin – Detección de enlaces no naturales:

La primera vez que Google ejecutó el algoritmo fue por el año 2012 y tuvo un impacto de al rededor del 3% en las búsquedas y el efecto que provoca es muy similar al Panda, desaparecen todas las visitas que proporcionaba el buscador, solo que en este caso se debe a la detección de enlaces hacia nuestra web, que se identifican como no naturales.

¿Qué busca Penguin?

Como adelantaba más arriba, Penguin trata de detectar enlaces hacia una web que no parezcan naturales. Cuando se lanzó por primera vez en 2012 fue revolucionario y poco a poco ha ido mejorando y haciéndose más preciso y complejo.

Como de costumbre Google no desvela todos los secretos del algoritmo, si no que va aportando pinceladas poco a poco y por ello podemos enumerar tres cuestiones que sabemos que el algoritmo identifica como enlaces forzados o que no parecen naturales.

- En primer lugar se comprueba la calidad de los enlaces, esto es, que los enlaces que se dirigen a un sitio web son tanto de alta calidad como de baja calidad. No sería muy natural que estos enlaces fueran todos muy buenos, como los que pueden aportar una red de blogs personal o todos bastante malos, como los que se suelen utilizar para hacer Blackhat, si necesitas ampliar conocimientos para conseguir buenos enlaces para tu estrategia de linkbuilding lee este post que vas a descubrir nuevas fuentes si o si fuentes de backlinks que no conoces.

- En segundo lugar se valora la temporalidad de los enlaces, de modo que si un sitio web presenta un crecimiento muy pronunciado en el número de enlaces en un periodo relativamente corto de tiempo y luego deja de recibirlos de pronto, parecerá sospechoso y puede que sea penalizado, ya que lo habitual es que un sitio web vaya sumando enlaces poco a poco y de forma más sostenida.

- En tercer lugar se presta atención a la disparidad en la clase de enlaces, los sitios web de calidad acostumbran a obtener sus enlaces de diversos tipos, como comentarios dentro de foros, publicaciones en blogs, o dentro de textos en diferentes webs, además hay que tener la precaución de variar el “anchor text” que empleamos para el enlace porque si utilizamos siempre el mismo seremos penalizados por Penguin con toda seguridad.

Como podéis comprobar el asunto no es sencillo… y es por este motivo por el que hoy en día ya no hay SEOs que hagan “blackhat” de este tipo, sino que normalmente se manejan entre el “greyhat” y el “whitehat”. Esto deja una cosa clara, si se quiere rankear en Google hay que establecer una estrategia de enlaces muy cuidadosa y elaborada para que este algoritmo no nos envíe de cabeza al fondo del pozo.

¿De qué forma penaliza el algoritmo Penguin?

En este caso, el algoritmo no penaliza directamente al conjunto del sitio web al que apuntan los enlaces, si no a secciones concretas a donde van dirigidos la mayor parte de los backlinks, aún así tiene muchísimo efecto en el tráfico que recibe nuestra web, ya que las páginas a las que dirigimos más enlaces, también deben ser las que más tráfico nos aportarán. Se han dado casos en los que el algoritmo en vez de producir una sanción al sitio web en cuestión, simplemente descuenta el valor de los enlaces que considera como no naturales y no tendrá un efecto tan drástico para nuestro tráfico.

A este algoritmo le ocurre algo similar a lo que pasaba con Panda, al ser tan grande (más que Panda incluso), tarda semanas en ejecutarse por completo, por lo tanto si analizamos nuestra web con la herramienta que comentábamos antes (Pangüin) para saber si hemos sido afectados por este algoritmo, debemos tener en cuenta también las fechas anteriores y posteriores a la fecha oficial de lanzamiento de la actualización del algoritmo. Si observamos que sufrimos un ligero descenso de las visitas, probablemente hayamos tenido suerte y sólo nos han descontado los enlaces perjudiciales, tal y como comentábamos anteriormente.

La siguiente pregunta que te estarás haciendo es si es posible salir de una penalización de Penguin, y si, se puede pero no sin bastante esfuerzo ya que además de realizar todas las acciones necesarias para solucionar el problema, al igual que pasaba con Panda, deberemos esperar a que Google lance la siguiente actualización y podamos comprobar si hemos logrado salir de la penalización.

Te dejo enlace a como recuperarse de una penalización SEO de Penguin

Mobile-Friendly: Posiciona en las búsquedas para dispositivos móviles:

Como todos sabréis ya, Google pretende ofrecer los mejores resultados posibles a las búsquedas que lanzan sus usuarios, esto supuso una evolución en los medios que ha utilizado para lograr esta utilidad. Desde el comienzo trataba de buscar y exponer en su listado de resultados el mejor contenido posible, y lo ha logrado con creces. Esto obliga a que todo el mundo actualice y mejore constantemente el contenido de sus sitios web para mantenerse en buenas posiciones dentro del buscador.

Hace unos meses, Google hizo pública su intención de llevar a cabo este mismo objetivo para todas las personas que realizan sus búsquedas desde sus dispositivos móviles, lo que se conoce como actualización de Mobile-Friendly, aquí tienes más información. El mundo del SEO enseguida se puso manos a la obra para adaptar sus páginas web a los dispositivos móviles, de forma que optimizase todas las opciones para este formato, y así, ser más útil y eficiente a los ojos de Google. Todo el mundo estaba convencido de que iba a provocar un efecto enorme en cuanto al posicionamiento, aunque más tarde se comprobó que tuvo una repercusión mucho menor de lo esperado, tan solo las páginas que prácticamente ni se cargaban en los dispositivos móviles fueron penalizadas en los rankings .

¿Que es para Google una web adaptada para móviles?

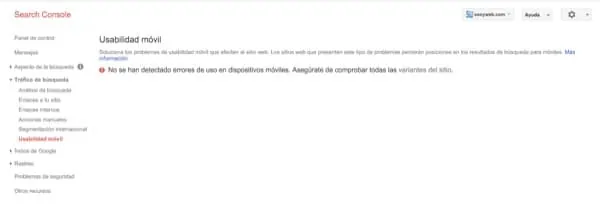

Como suele ser habitual, Google vuelve a ser un poco ambiguo al definir lo que considera como una web amigable o no para los dispositivos móviles. Es por este motivo, que Google mayormente ha penalizado a las webs que eran un verdadero desastre. Así y todo tenemos la posibilidad de comprobar que opinión tiene Google de nuestra página web en lo que adaptación para móviles se refiere, entrando en la herramienta Mobile-Friendly o también en Search Console, (antiguo Web Master Tools). En función del color que aparezca cuando introduzcamos nuestra URL, sabremos si hay que mejorarla o si no es necesario.

Es recomendable comprobar no solo la portada si no también otras páginas para asegurarnos que todas cumplen con las expectativas de nuestro amigo Google.

Es interesante conocer el “Manual de SEO para móvil”, de Google, donde nos enseña los fallos que más a menudo se cometen, como los errores en las redirecciones móviles o tener bloqueado el javascript. Otras cuestiones muy importantes que debemos contemplar sería no utilizar el software “Flash”, ya que no es compatible con la mayoría de dispositivos móviles, pero vamos esta tecnología tampoco debes utilizarla en una web si quieres tener un bueno posicionamiento SEO. Tampoco debemos situar varios enlaces muy juntos ya que podrían ser difíciles de diferenciar con el dedo en un teléfono móvil. Debemos adaptar el tamaño de los textos para que se ajusten al tamaño de estos dispositivos y a poder ser que superen los 16px para que sea aún más fácil de leer.

El devenir del Mobil-Friendly

Sería un error pensar que como esta actualización no ha sido muy significativa podemos olvidarnos de hacer todas las mejoras posibles para adaptar nuestra web a los elementos móviles ya que nunca se sabe cuando puede Google sacar una nueva actualización de este algoritmo y con la dificultad añadida de que si somos penalizados, no podremos advertirlo observando variaciones bruscas en el número de visitas en nuestro sitio web, esto es debido a que lo que hace este algoritmo es posicionar más arriba a las webs que si están bien adaptadas para dispositivos móviles. Herramienta Google SEO para móviles

Top Heavy – Procura tener un sitio web compensado

Esta penalización tiene el objetivo de evitar que los usuarios que establecen una búsqueda en Google, queden insatisfechos con los resultados ofrecidos por el buscador. Esta insatisfacción, tal y como informa el propio buscador se produce porque los usuarios no encuentran lo que están buscando dentro de los sitios web que les han ofrecido. Las quejas en este sentido hacen referencia a que les resulta difícil encontrar dentro del texto principal lo que están buscando o a que se encuentran de primeras con un montón de publicidad. Entonces podemos concluir que las páginas con escaso contenido van a padecer los efectos de este algoritmo.

Top Heavy se lanzó en 2012 por primera vez. aquí tienes más info en ingles

¿Cómo se aplican las sanciones de Top Heavy?

Esta penalización es de las que nos daremos cuenta rápidamente porque afecta a todo nuestro sitio web y veremos que todo nuestro sitio web se cae de los rankings, todo por igual, no afectando a unas páginas si y a otras no. Para aclarar las dudas más importantes Google publicó un artículo explicativo donde precisaba que solo se penalizarían los sitios en los que la mayoría de sus páginas fueran catalogadas como “Top Heavy”, por lo que si esto ocurría solo con unas pocas páginas, no debería ser un problema para nosotros.

La última cosa importante que hay que saber sobre este algoritmo, aporta una cosa buena y mala al mismo tiempo. La buena es que se ejecuta muy pocas veces, y la mala es que si nos penaliza, ocurre lo de siempre, que deberemos esperar a que se vuelva a ejecutar para salir de su propia sanción, lo que por lo tanto nos podría llevar bastante tiempo.

¿Qué hacer para que no nos afecte el Top Heavy?

Pues la respuesta es muy simple, sencillamente hay que evitar excederse de poner anuncios en la portada, encima del texto principal de nuestra página y así podremos ofrecer una buena experiencia a los usuarios que nos visiten, que encontrarán lo que buscan y si luego aparecen anuncios más abajo cuando ya han encontrado lo que buscaban, probablemente no se molestarán y Google verá nuestro sitio web con muy buenos ojos y pasará inadvertido para este algoritmo, en resumen encontrar un buen equilibrio entre contenido y anuncios. Aquí os dejo un ejemplo de sitio web que sería penalizado:

El algoritmo Payday- Spam a sitios de pago:

Las personas que hayan estado relacionadas con el marketing on-line, seguro que saben que los negocios considerados como oscuros, juegos de casino, páginas eróticas, etc, son un nicho muy lucrativo, y por eso los auténticos SEO que se manejan en el blackhat mantienen una dura competencia para posicionar palabras clave en todos estos nichos y obtener suculentos beneficios.

Como sabemos, Google lleva tiempo tratando de cazar a los SEO que se dedican a hacer blackhat, y es concretamente con este objetivo con el que lanzaron el algoritmo Payday. Este algoritmo penaliza los sitios considerados spam para este tipo de nichos, y ha logrado un gran efecto contra los blackhat SEOs, de nivel intermedio y de los novatos, pero no ha conseguido descolgar de las primeras posiciones a los mejores y cuando son capaces de localizarlos y penalizarlos estos SEOs ya le han sacado el partido suficiente a sus sitios web, han sido capaces de manipular a Google lo suficiente como para sacarle la máxima rentabilidad.

Este algoritmo, se vió por primera vez en el año 2013 y se dirigió a palabras clave como, Viagra, casinos, préstamos, etc…

Se han sucedido diferentes actualizaciones de este algoritmo con el objetivo de ir perfeccionándolo, de modo que si tu intención es seguir trabajando sobre nichos spam, debes hacerlo de forma muy limpia y cuidadosa, si no con el tiempo acabarás siendo penalizado con seguridad. Si esto ocurre. Simplemente cambia de nicho y listo, salvo que tengas un sitio bueno de verdad, entonces como siempre, tendrás que solucionar los errores y esperar a que se envíe de nuevo el algoritmo.

Google pirate en contra de la piratería informática:

A pesar del firme objetivo de Google, de mostrar siempre los mejores resultados para lo que buscan sus usuarios, Google ha tomado una fuerte determinación con respecto a la piratería informática y la protección de los derechos de autor del material audio-visual. Incluso hay países donde se considera delito y en la mayoría una actividad de falta de ética. El algoritmo Pirata nació con la intención de reducir el tráfico proveniente del buscador hacia los sitios web de descarga de torrents, como muestra la siguiente gráfica, y que en un primer momento logró su objetivo:

Aunque no saco los resultados del buscador, si les hizo perder la mayoría de sus visitas:

No pueden eliminar estos sitios web de los resultados porque no todo el contenido que ofrecen corresponde con material robado o ilegal, a lo que hay que sumar que las búsquedas lanzadas por nombre de marca no se vieron influidas por el algoritmo.

Un ejemplo de página que perdió gran parte de su tráfico fue free-tv-video-online.me que prácticamente perdió la totalidad de sus visitas provenientes del buscador.

¿Cómo funciona Pirate?

La principal intención del algoritmo no era eliminar por completo los sitios de descarga torrents, si no eliminar los resultados para algunas consultas determinadas.

Por ejemplo, si alguien pone en el buscador el nombre de una serie y un capítulo concreto, antes del lanzamiento de este algoritmo aparecerían resultados torrent desde los que se podría descargar este capítulo. A partir de la entrada en vigor de Pirata, estos resultados ya no aparecen, solo se verían resultados donde el visionado fuese legal, como una página oficial o páginas con algún tipo de trailer o similar, completamente legítimo.

Este algoritmo trabaja sobre avisos de violación de derechos de autor. Cuando un sitio web llega a acumular cierto número de denuncias de estas violaciones al derecho de autor, Pirate lo penalizará y hará que caiga drásticamente en los resultados de búsqueda.

Es decir, que un sitio nuevo con torrents de descarga comenzará rankeando con normalidad, pero según acumule estas denuncias, terminará sancionado por este algoritmo.

Como dato informativo, os comentaré que Google recibe millones y millones de este tipo de denuncias contra los derechos de autor semana tras semana.

Algunas veces resulta que las denuncias no están en lo cierto por no tratarse de contenido protegido por derecho de autor, por lo que Google siempre hace sus comprobaciones antes de penalizar a un sitio web de estas características.

Lo que está claro es que si no queremos ser sancionados por el algoritmo Pirate, lo que hay que hacer es no robar contenido o por lo menos no demasiado ;).

Penalizaciones manuales

Enlaces no naturales – Diversifica y gana (penalización manual):

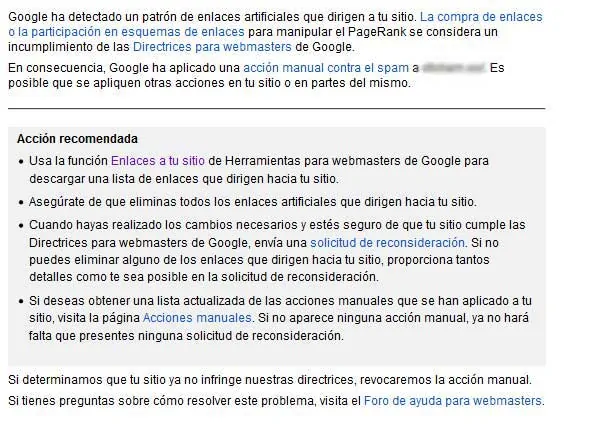

Las penalizaciones manuales son muy duras cuando provienen de los empleados de Google. Estas se producen cuando de forma manual trabajadores de Google, examinan un sitio web y descubren que este sitio contradice sus directrices de calidad. Este tipo de penalización le es notificada al webmaster a través de la herramienta de search console.

De los más importantes elementos de clasificación sigue siendo el de los enlaces o backlinks que presenta una página web, por eso los SEOs han trabajado sobre ellos desde que se supo de su importancia para aprovecharse de su fuerza de posicionamiento.

Google comenzó a revisar manualmente estos enlaces considerados como no naturales para combatir esta circunstancia.

Si la persona que hace las comprobaciones advierte que los enlaces provienen de una granja de enlaces o que son enlaces de pago, aplicará esta sanción a todo el sitio web en cuestión.

Diversidad de sanciones por enlaces considerados “no naturales”

Hay muchas penas diferentes y con efectos diferentes para los sitios web con enlaces no naturales. Desde la herramienta de Google, Search Console, podremos ver en todo momento si tenemos alguna sanción manual que afecte a nuestro sitio web:

A continuación os comento los tres tipos de advertencias más habituales que nos podemos encontrar:

- En primer lugar, es conveniente saber que si nos aparece el mensaje de “enlaces no naturales a sus sitios de impacto” significa que en una revisión natural se han encontrado estos enlaces negativos, pero al mismo tiempo no hay nada que indique que nosotros tuvimos algo que ver con su creación, entonces no seremos realmente penalizados, si que es verdad que quizás perderemos alguna que otra visita, pero solo causado por que el enlace considerados como no natural se descontará de nuestro número total de enlaces. Ante esta situación concreta lo único que tenemos a nuestro alcance es realizar un Disavow.

- En segundo lugar, si aparece el mensaje “enlaces no naturales a su sitio web”, podemos estar seguro de que hemos sido penalizados, es posible que solo unas páginas concretas o todo nuestro dominio en conjunto. Esto quiere decir que el revisor considera que esos enlaces no naturales que apuntan hacia nuestro sitio web han sido creado por nosotros mismos con el único fin de alterar los resultados naturales de Google.

- En tercer lugar, podría aparecer el mensaje “enlaces no naturales desde su sitio web”, esto suele producirse porque han detectado que muchos de nuestros enlaces salientes apuntan hacia otros sitios web concretos con el mismo anchor text, o palabra clave exacta. Este tipo de penalizaciones también pueden afectar a páginas concretas o a todo el sitio web en general.

El establecimiento de penalizaciones manuales

Partiendo de la base de que ninguna penalización es positiva, con las penalizaciones manuales tenemos la opción de solicitar a Google la reconsideración de nuestro sitio web cuando hayamos solucionado los errores que habíamos cometido y por los que nos habían sancionado. Si realmente lo solucionamos correctamente, nos levantarán la sanción y volveremos a rankear con cierta normalidad dentro del buscador.

Existe una guía publicada por Google para poder consultar las penalizaciones de cualquier tipo de sanción, también te facilito un enlace al blog de un colega y paisano mío que lleva muchos años como experto seo Juan Luis Mora.

Spam- Si vas a hacer spam, ten en cuenta estas consideraciones:

El spam consiste en mucho más que enviar enlaces y enlaces sin parar a un sitio web determinado. Cuando se trata de penalizaciones manuales, abarca también los contenidos que se crean de forma automática, contenidos deficientes o en el peor de los casos contenido malicioso, entre otros muchos ejemplos que podríamos enumerar.

Del mismo modo que ocurría en la penalización manual anterior, si nos afecta una sanción de este tipo nos aparecerá algún mensaje de los siguiente:

- El primero que os explicaré aparecería así reflejado: “Puro spam”, en este caso el revisor de la página ha detectado que la gran mayoría o directamente todas las páginas de nuestro sitio web es sin lugar a dudas spam puro y duro. Si este fuera vuestro caso, ya os digo de antemano que es prácticamente imposible salir de este tipo de penalizaciones manuales.

- El siguiente mensaje que podría aparecer sería: “Spam generado por el usuario”, esto suele ocurrir en los sitios web en los que se permite a los usuarios del mismo enviar contenido, ya que este contenido o enlaces que dejan en nuestra web, muy fácilmente puede tratarse de Spam. Normalmente a través de un foro que tengamos activo o de comentarios. Esta sanción a diferencia de la anterior si puede ser superada.

- El último ejemplo sería el relacionado con este mensaje: “Freehost Spammy”. Este mensaje aparecerá cuando resulte que tengamos nuestra web alojada en un servidor que Google tenga catalogado como servidor spam, que es donde se suelen alojar la mayoría de SEOs que se dedican a hacer blackhat y nutren de spam toda la red. Como es fácil de deducir, estos servidores suelen ser muy baratos o incluso gratuitos. La solución parece clara, mantenerse alejado de este tipo de servidores y en caso de que sea demasiado tarde, y ya tengamos encima una sanción de este tipo, lo único que queda es eliminar todo el spam de nuestro sitio web y tratar de cambiar el servidor por uno que no sea sospechoso para Google.

Poco contenido sin que aporte nada de valor

En el caso de que con el algoritmo Panda, Google no haya sido capaz de eliminar de sus resultados las páginas web con poco contenido puede tratar de hacerlo mediante una revisión manual. El revisor buscará en nuestra web textos que no alcancen un tamaño mínimo, considerado como indispensable o bien contenido repetido o copiado, ya sea dentro de nuestro propio sitio web o bien sea de otras páginas.

Si el revisor de Google considera que el contenido está duplicado o es escaso, seremos penalizados y sufriremos una caída enorme en nuestro tráfico de visitas .

Alguno de los casos que suponen webs con poco valor para Google, son aquellos en los que se encuentre un sitio web con información que se genera automáticamente, texto que provenga de otros sitios o de mala calidad como los que se pueden encontrar en un foro, páginas de afiliados o páginas que directamente están vacías de contenido.

Desde la herramienta Search Console de Google, podemos comprobar si nos ha afectado este tipo de sanción manual

Al igual que sucedía con las penalizaciones anteriores, debemos prestar atención a si esta sanción nos ha afectado a la totalidad de nuestro sitio web, o bien sólo se han detectado coincidencias en una o pocas páginas de nuestra web. En función de esto como es lógico, tendrá su reflejo en la caída del número de visitas, que se acercarán a cero o bajarán sólo ligeramente.

Conclusiones:

Todas las sanciones se pueden evitar a base de aprendizaje, es el día a día de un SEO y si como buen profesional se comprenden los motivos y las necesidades de las penalizaciones, podremos evitarlas, sobre todo porque muchas son merecidas y fácilmente evitables. Cuando tengamos estas penalizaciones que hemos comentado bien controladas y aprendidas podremos usar el registro de cambios en los algoritmos de Google que nos ofrece MOZ, para estar siempre actualizados y prevenidos ante los cambios que podrían hacernos perder mucho tráfico hacia nuestros proyectos.

Siempre hay que estar alerta ante posibles penalizaciones, porque si podemos advertirlas antes de que nos afecten, podremos corregir lo que hayamos hecho mal y evitar una dura penalización por parte de Google.

Este post ha sido posible gracias a la fuente quicksprout

Hola, enhorabuena al autor de este post, sencillamente «un señor articulo». He disfrutado de esta exposición impecable con la que he aprendido y aclarado dudas. También me ha encantado la herramienta Panguin Tool.

Un saludo.

Extraordinario el artículo, vamos a ir punto por punto a ver si quitamos todo lo que nos está perjudicando, gracias por el aporte lo dejo en favoritos

Tremendo articulo, estaba buscando esta info y la encontre toda en un solo lugar!! Saludos